El chatbot ChatGPT genera textos increíbles sobre cualquier tema y tiene respuestas a cada pregunta. Nos fijamos en las posibilidades y limitaciones de la tecnología.

Cuando la compañía OpenAI introdujo ChatGPT a fines de 2022, comenzó la gran exageración. En cinco días, el CEO Sam Altman reportó más de un millón de usuarios registrados. El chatbot inicialmente se convirtió en víctima de su propio éxito: podría suceder que ChatGPT respondiera a sus usuarios muy lentamente o incluso cerrara sus puertas debido a multitudes demasiado grandes.

TE PUEDE INTERESAR: 5 consejos para disfrutar mejor de ChatGPT

Los modelos de lenguaje de IA no son nuevos. GPT-3, por ejemplo, en el que también se basa ChatGPT, existe desde 2020. Pero no fue hasta el lanzamiento de ChatGPT que quedó claro para un público amplio qué potencial puede desarrollar esta tecnología.

NO COMPACTO

ChatGPT es el modelo de lenguaje simple y gratuito de OpenAI, que responde preguntas a través del chat y genera textos arbitrarios.

Sus posibilidades son extremadamente poderosas. Cambiarán procesos fundamentales en muchas industrias.

Sin embargo, ChatGPT tiene limitaciones claras: no hay garantía de que toda su información sea correcta y completa.

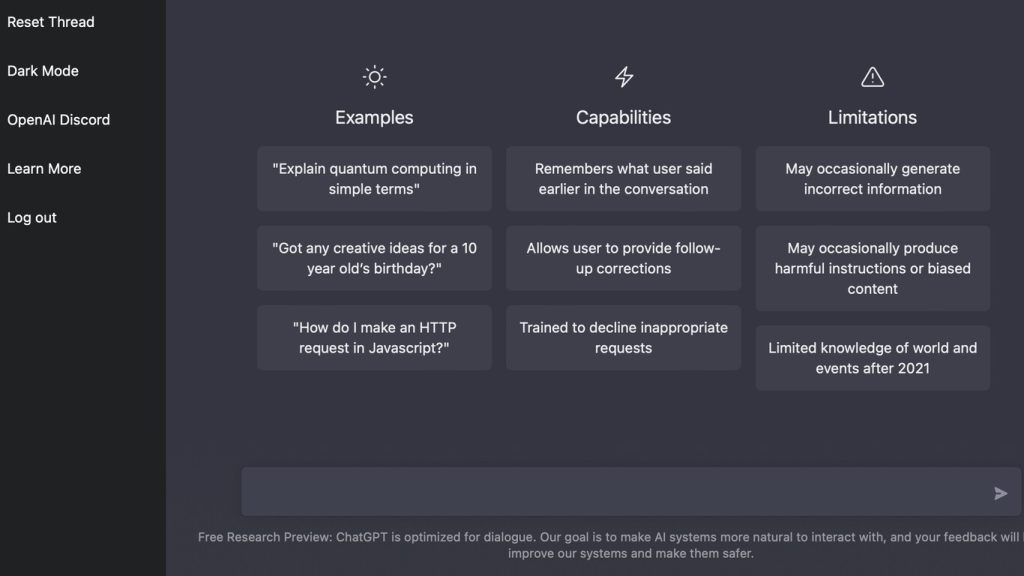

Mientras que los modelos de lenguaje eran anteriormente bastante complicados de usar (o solo a través de una interfaz de programación), ChatGPT viene con una interfaz impresionantemente simple: simplemente chatea con el sistema a través del teclado y el navegador. La digresión en la última página describe en detalle las optimizaciones que OpenAI ha realizado para hacer que las capacidades del GPT-3 subyacente sean accesibles a un público amplio.

Alarma en la sala de profesores

Con la aparición de ChatGPT, rápidamente quedó claro que los estudiantes podrán delegar algunas tareas a la IA en el futuro: un resumen del jinete del molde, por ejemplo, escupe el bot en segundos. Al resolver un sistema lineal de ecuaciones, el chatbot incluso explica la solución en detalle. Apenas hay una asignatura escolar en la que no pueda ayudar. El propio ChatGPT escribe a pedido: «Puedo ayudarlo a responder preguntas sobre una variedad de temas, incluyendo matemáticas, física, química, biología, historia, literatura, geografía, política y mucho más».

La Autoridad Escolar del Condado de Nueva York prohibió rápidamente el uso del chatbot. La razón: no ayuda practicar el pensamiento crítico y las habilidades de resolución de problemas. Heinz-Peter Meidinger, presidente de la Asociación de Profesores Alemanes, reaccionó con más calma a ZDF: Los estudiantes han tenido durante mucho tiempo la oportunidad de obtener ayuda en Internet. Los maestros notarían rápidamente si alguien había resuelto tareas de forma independiente, dijo a la estación. Y Robert Lepenies, presidente de la Universidad Internacional Karlshochschule en Karlsruhe, incluso quiere integrar la inteligencia artificial en las operaciones de seminarios de su universidad. El mundo académico ya está discutiendo cómo se debe reconocer la contribución de ChatGPT al trabajo académico.

Pero ChatGPT no solo facilita la redacción de tareas y trabajos académicos. Bajo demanda, el chatbot genera textos de varios géneros en varios idiomas: desde titulares, publicaciones en redes sociales y poemas hasta textos más largos como boletines, discursos, comunicados de prensa o cartas de presentación, y en diferentes idiomas. Puede refinar, estructurar y resumir textos lingüísticamente. Si lo desea, puede diseñar novelas completas en combinación con ChatGPT, con una estructura aproximada y subtramas. Por último, pero no menos importante, ChatGPT escupe código de muestra para muchas tareas de desarrollo de software y analiza los programas dados en busca de errores.

Bombo y manejo de la información

Envía mensajes de texto AI en todas partes

Con ChatGPT, los modelos de voz tienen su momento iPhone. Como recordatorio: cuando Steve Jobs presentó por primera vez el teléfono inteligente en 2007, ya había teléfonos móviles con conexión a Internet o pantalla táctil. Pero solo el iPhone allanó el camino para el triunfo de los teléfonos inteligentes. En consecuencia, ahora todos pueden ver y probar por sí mismos qué usos prácticos hacen posible los modelos de lenguaje. El bombo actual en torno a ChatGPT es solo el comienzo, la tecnología fluirá rápidamente hacia otros servicios y aplicaciones. Hoy en día ya es posible integrar los servicios de ChatGPT en cualquier formulario web a través de extensiones de navegador o enriquecer los resultados de búsqueda de Google con resultados de ChatGPT. Y algunos motores de búsqueda ya están ensamblando respuestas a medida utilizando un modelo de lenguaje.

En el futuro, la ayuda de la IA será una cuestión de rutina dondequiera que se escriban los textos. Si la autocorrección subraya errores tipográficos en usuarios normales de hoy, puede tener una estructura de documento y sugerencias de texto enviadas mañana en caso de bloqueo del escritor o todo el correo electrónico se puede escribir en contenido y tono adaptados al destinatario.

En cualquier caso, Microsoft confía en OpenAI y ChatGPT. El gigante del software quiere invertir diez mil millones de dólares estadounidenses en OpenAI y ha anunciado que integrará ChatGPT en su motor de búsqueda Bing. Los terceros podrán integrar el chatbot en sus aplicaciones a través de los servicios en la nube de Microsoft. En OpenAI, ChatGPT se ejecuta actualmente en modo beta y es gratuito para los usuarios. La compañía aparentemente está preparando un modelo freemium para su chatbot: por una tarifa mensual, OpenAI quiere ofrecer acceso, respuestas más rápidas y acceso más rápido a nuevas funciones incluso bajo alta carga.

Tras el éxito de ChatGPT, se puede suponer que todas las principales empresas de tecnología reaccionarán rápidamente. En cualquier caso, Google está actualmente «enloqueciendo» con ChatGPT, como informa la revista en línea The Verge. En consecuencia, Google quiere lanzar 20 nuevos productos de IA «este año», incluida una demostración de un motor de búsqueda con capacidades de chatbot.

Medio conocimiento peligroso

A pesar de todo el entusiasmo sobre las capacidades de ChatGPT y otros modelos de lenguaje, no hay que perder de vista las limitaciones de estos sistemas. Por lo tanto, ChatGPT & Co. produce oraciones hermosas y bien construidas. Incluso si la etiqueta «inteligencia artificial» se adhiere a los modelos de lenguaje, no tienen un conocimiento real del mundo. Dado que los textos solo se basan en probabilidades de palabras, puede aparecer información falsa. En el siguiente artículo, mostramos algunos ejemplos, como cómo «persuadimos» a ChatGPT para que considere que 5 + 5 = 11 es correcto.

En la actualidad, es casi imposible comprobar si un texto proviene de la pluma de un humano o de una IA. Tal vez sea más probable que la información sea cuestionada si proviene incontrolablemente de una máquina expendedora que si ha sido escrita por una persona cuya experiencia en el tema puede incluso ser conocida. Esto hace que sea aún más importante etiquetar los textos que han sido escritos completamente por una IA. En enero, se supo que el portal en línea CNET había publicado docenas de artículos de IA sin verificar sin marcarlos como tales. El contenido generado por IA también puede conducir a derechos de autor y otros problemas legales. El artículo trata estas y otras cuestiones legales de texto, imágenes y otros contenidos generados por IA.

Resultado

Calcular, leer, escribir, dejar que una IA escriba un texto: Si aún no has probado ChatGPT, deberías hacerlo. Tarde o temprano, el uso de herramientas de texto de IA se convertirá en una de las habilidades digitales básicas. Los textos ficticios y artísticos, en los que el contenido de la verdad y los hechos no juegan un papel importante, suceden a la IA sorprendentemente bien. Es divertido que el bot escriba un poema sobre la Ley de Transferencia de Tareas de Supervisión de Etiquetado de Carne o una historia sobre los términos que son tendencia en Twitter en este momento.

Antecedentes: Funcionalidad y formación

Red de transformadores

ChatGPT se basa en el modelo de lenguaje GPT-3, que OpenAI desarrolló en 2020. GPT-3 produce textos en un inglés casi impecable y en cualquier estilo. La red neuronal aprendió esto con la ayuda de terabytes de texto de Internet en el llamado preentrenamiento, de ahí la P en el nombre. Al hacerlo, ha aprendido a seguir escribiendo lo más similar posible a los datos de entrenamiento (generativo, la G del nombre).

GPT-3 es una red Transformer (la T del nombre), una estructura de red recientemente desarrollada con una nueva idea crucial: los transformadores utilizan un mecanismo de atención en cada una de sus capas. Este mecanismo puede considerarse como una red neuronal minimalista que aprende lo que no es parte del tema. A través de este mecanismo, los transformadores aprenden a centrarse en datos específicos. En un artículo separado, explicamos Transformer en detalle. El mecanismo también permite entrenar redes neuronales a una escala sin precedentes. GPT-3 tiene 175 mil millones de parámetros, mucho espacio para el lenguaje y el conocimiento del mundo.

GPT-3 puede producir textos que parecen como si simplemente hubiera copiado o copiado material existente de Internet. Si intenta hacer preguntas al modelo de lenguaje como una contraparte humana, a menudo proporciona respuestas vacías o incorrectas y, a veces, contrapreguntas. Nadie duda de las habilidades lingüísticas de GPT-3, pero no están «alineadas» con los humanos lo suficientemente bien como para responder a ciertas preguntas satisfactoriamente. OpenAI llama al problema «alineación».

Pueden ocurrir dos problemas al entrenar redes neuronales. O bien el algoritmo de aprendizaje salta hacia adelante y hacia atrás, porque los datos de entrenamiento siempre causan grandes cambios en los parámetros. Esto sucede cuando hay mucho ruido en el conjunto de datos y la red no puede reconocer ninguna estructura en él. O los datos no dan una dirección clara (gradientes que son demasiado pequeños), por lo que el algoritmo apenas cambia nada en los parámetros. OpenAI tuvo el segundo problema con GPT-3. Entonces, ¿cómo podría calcular gradientes que son grandes exactamente cuando el modelo de lenguaje hábilmente pierde la pregunta?

Formación en IA

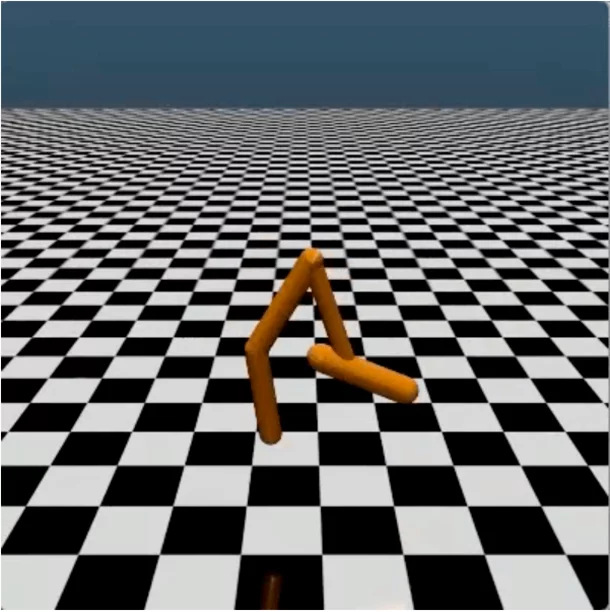

Para la respuesta, los investigadores utilizaron una idea del aprendizaje por refuerzo. Entrenas a un agente que hace cosas en un entorno de juego y es recompensado o castigado de vez en cuando. Los investigadores de esta disciplina suelen probar sus IA con juegos de arcade pixelados de los años 80. El problema con esto es que los puntos solo se otorgan después de toda una serie de movimientos y la IA tiene que descubrir por sí misma durante el entrenamiento qué movimiento fue importante en última instancia para ganar el punto para aprender a hacerlo más a menudo. La solución habitual es entrenar una pequeña red neuronal que predice si habrá puntos pronto. Su evaluación luego utiliza el algoritmo de aprendizaje para el agente y obtienes una señal de aprendizaje para cada movimiento.

No necesitas mucho más para pong y breakout porque los juegos a menudo otorgan puntos y la IA no tiene tantas opciones. Pero si quieres enseñar a una figura de palo un salto mortal en una simulación física, hay demasiadas maneras de mover un gran número de articulaciones individuales. La probabilidad de encontrar aleatoriamente la secuencia correcta de movimientos es prácticamente cero. Si una persona observa la figura de palo retorcido que yace en el suelo en sus contracciones, inmediatamente ve que esto no sucederá.

(Imagen: OpenAI, https://openai.com/blog/deep-reinforcement-learning-from-human-preferences/)

Figuras de palo en movimiento

OpenAI ha hecho uso exactamente de esta experiencia: permiten a los humanos evaluar dos intentos de movimiento de las figuras de palo y utilizaron esta información como datos de entrenamiento para una red neuronal que predice lo que diría un humano. Con la red, OpenAI entrenó al agente de aprendizaje de refuerzo, lo hizo temblar un poco más hábilmente y la gente decide de nuevo, y así sucesivamente. Después de unos pocos cientos de carreras de este tipo, la figura del palo había aprendido un salto mortal pasable. OpenAI llama a esta idea combinada con una función de pérdida algo más complicada («función objetiva» en el aprendizaje por refuerzo) «Optimización de políticas próximas», PPO para abreviar.

La función Pérdida determina cuándo el algoritmo de aprendizaje recompensa o penaliza una red neuronal. Para una capacitación efectiva, la función debe proporcionar suficiente retroalimentación para lograr un progreso notable en cada paso de aprendizaje, pero no tan extremo como para que la red arroje todo su conocimiento previo por la borda. En los últimos años, la mayoría de los avances en las redes neuronales se han debido a mejores funciones de pérdida en lugar de una estructura de red diferente.

De figura de palo a garabato

La idea de que los humanos generan los datos para una función de pérdida entrenada funciona no solo con juegos de arcade y simulaciones de física, sino también con juegos de preguntas y respuestas: OpenAI permitió que GPT-3 respondiera preguntas varias veces de manera diferente y pagó a las personas para que ordenaran las diferentes respuestas según su utilidad. Con este conjunto de datos, que es demasiado pequeño en comparación con el entrenamiento previo, entrenaron una red pequeña y la usaron con PPO para optimizar GPT-3. Para que no olvidara por completo sus habilidades anteriores, rociaron repetidamente carreras de entrenamiento de acuerdo con el viejo esquema. PPO nuevamente entregó gradientes significativamente más grandes, y el modelo de lenguaje mejoró incluso sin neuronas adicionales. OpenAI llama al GPT-3 reentrenado InstructGPT para una mejor alineación, porque sigue mejor las instrucciones de las instrucciones.

En el último paso, InstructGPT finalmente creó ChatGPT integrando el contexto de la conversación anterior en el modelo de lenguaje. Esto incluye tanto las preguntas como sus propias respuestas. Mientras que GPT-3 estaba limitado a 2048 tokens (es decir, alrededor de 8000 caracteres para textos en inglés), ChatGPT tiene en cuenta cualquier cantidad de texto del chat.

2 comentarios en «Por qué el generador de texto AI ChatGPT es tan fascinante»